Azure にHadoopディストーションのHortonworksを構成してみる

検証用にSparkやHadoop・Hive・HDFS等の環境が一式ほしいなー、と思っていたんですが、何やらHortonworksが良いらしいというのをUSのメンバーに聞き、早速試し見てみました。

はじめローカルで環境を構成しようとしたんですが、あまりにも把握するべき情報が多すぎて、心がオレマシタ。

Hortonworksとは?

エンタープライズ企業向けビッグデータ処理のためのHadoopディストーションの一つとのこと。

参考記事

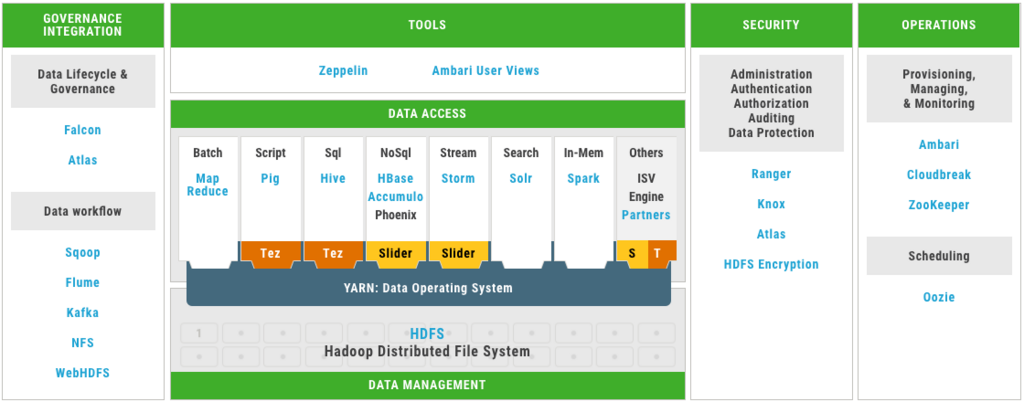

リソース管理フレームワークにはYARN

DataAccessのためのフレームワークとして、Hadoop Mapreduce、Hive、Sparkが利用できて、しかもそれらを扱うためのToolsとしてZeppelin、

全体の管理用ツールとしてもAmbariがはいっている、まさにオールインワンなビッグデータ処理のためのディストリビューション。ありがたい。

Azureで、Hortonworks Sandboxを使い、Hadoop、Sparkを試してみよう

しかし、あまりにもコンポーネントが多すぎて、何が何やら把握しきれないのも事実。

各コンポーネントの説明は、以下のHortonworks チュートリアルの資料がわかりやすいです。

必要なもの

- Azure サブスクリプション

Azureでの構成手順

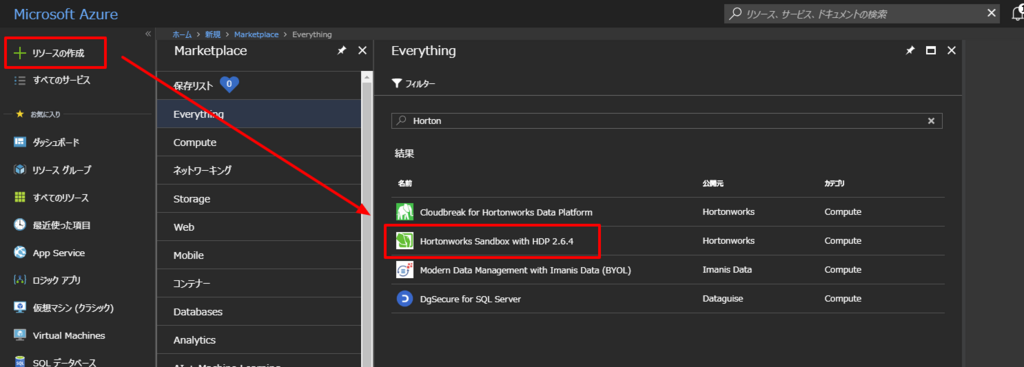

- Azure Portlにログインし、「+リソースの追加」から「Hortonworks Sandbox」を選択

- 以下のリソースで作成を実行します。

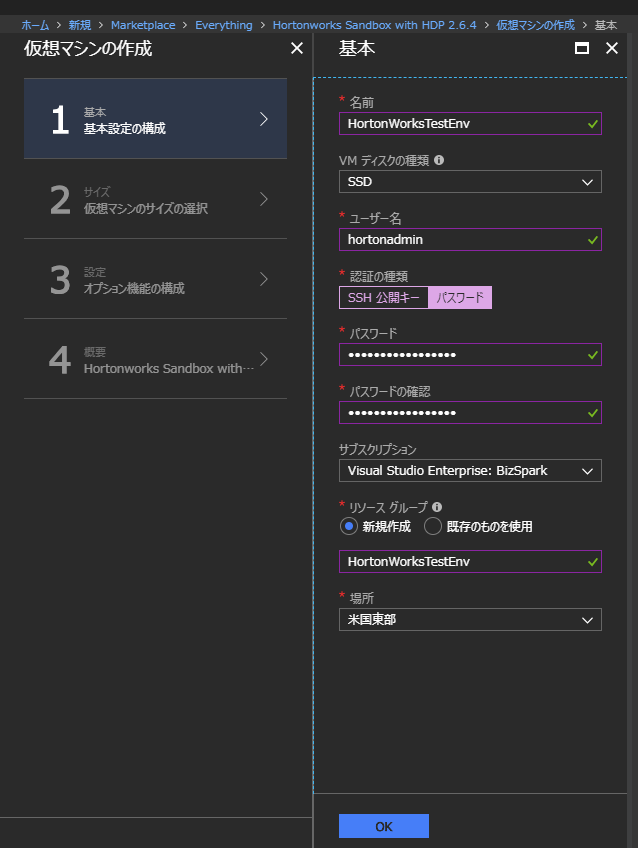

- 基本設定の構成では、各種項目を任意の内容で入力します。認証の種類は今回パスワードを選択しました。場所は近いところがいいでしょう。

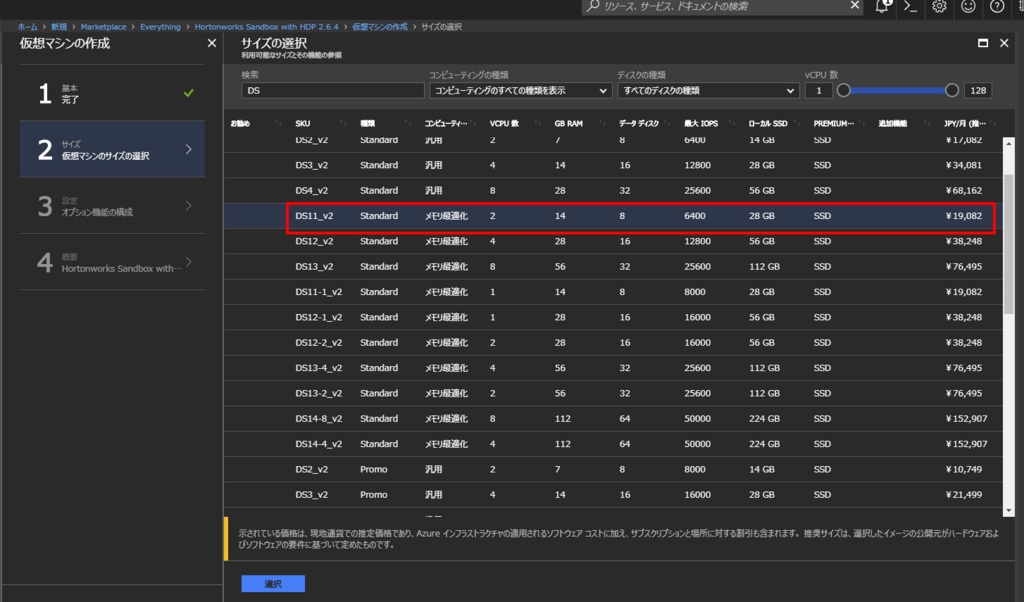

- 仮想マシンのサイズは小さすぎると動かないらしいです。今回はHortonworksの方のQiita記事を参考に、「DS11_V2 Standard 」を選択しました。

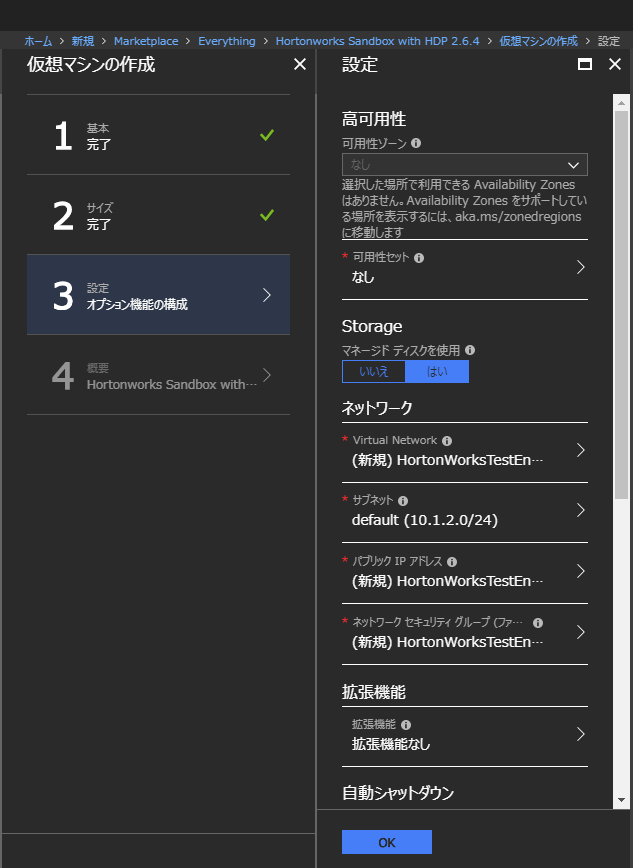

- オプション機能の構成はデフォルトで進めます。場合によっては、無駄な課金を防ぐために自動シャットダウンを付けるのがいいと思います。

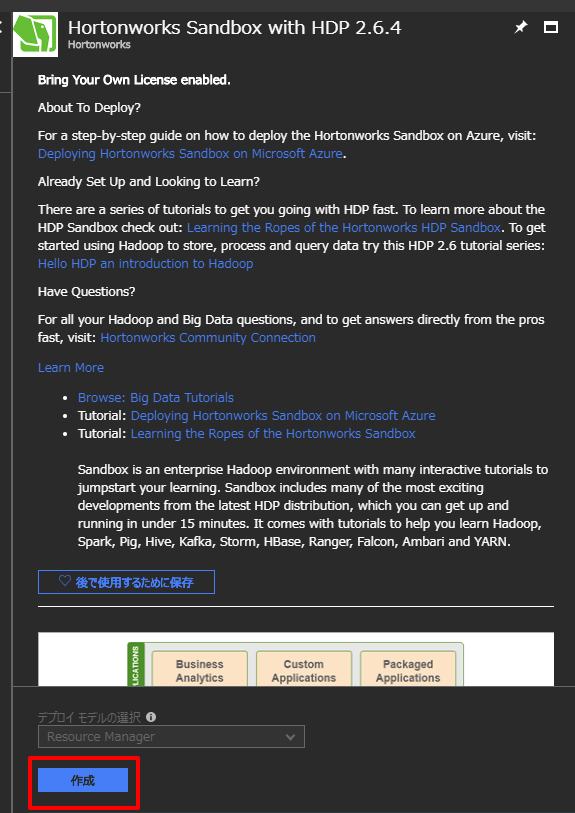

- 検証結果を確認の上、作成をクリックします。どうやらマイクロソフト MVPのサブスクリプションでは、マーケットプレイスの料金が別途かかるようですが、Hortonworks Sandboxそのものは無償なので問題はありません。

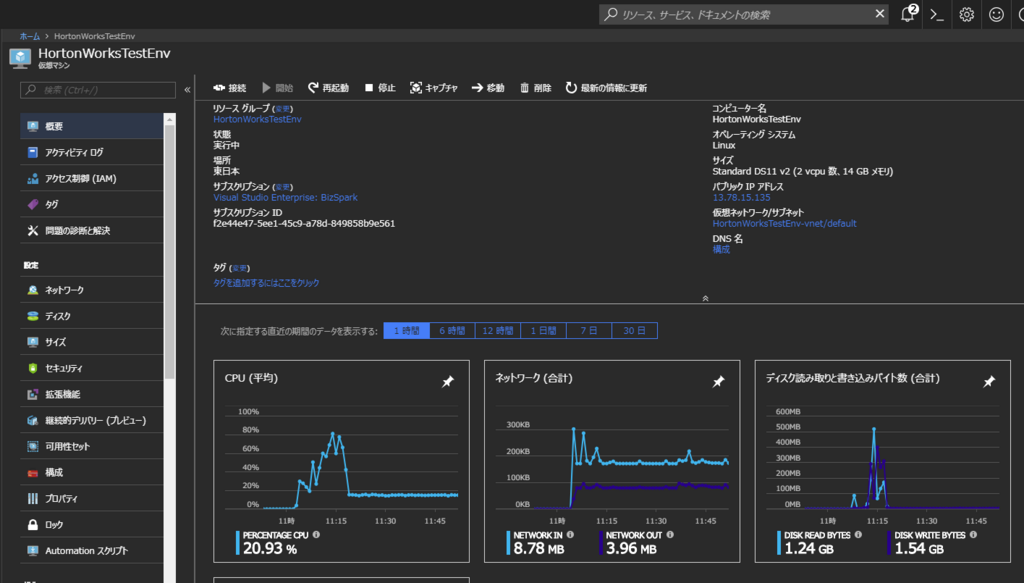

- これで構成が完了しました。

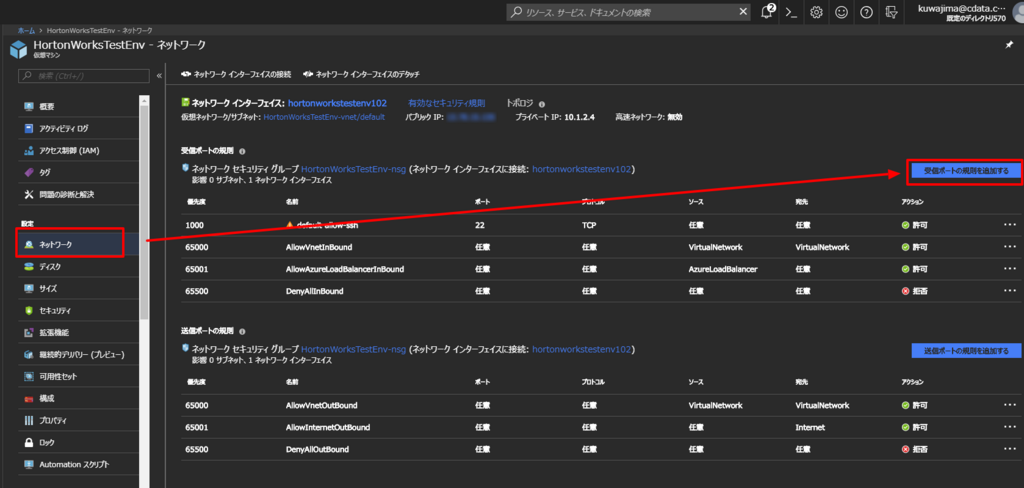

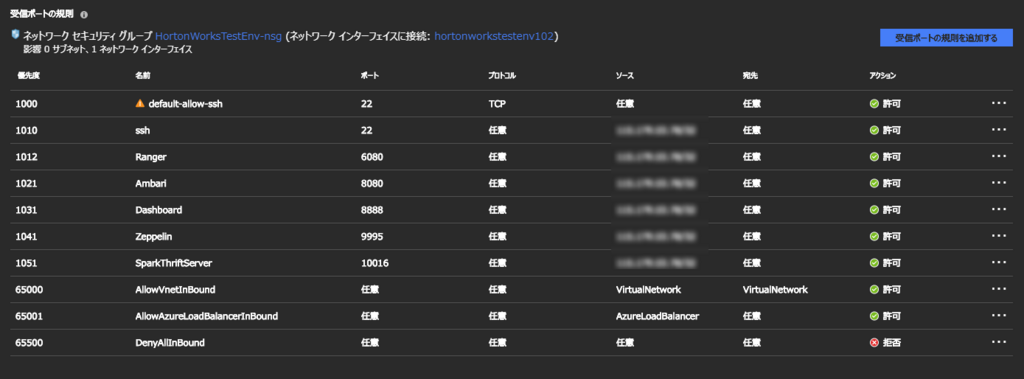

ネットワークの構成

Portリストは以下から確認できます。私はSparkも最終的に使用したいので、Sparkポートを開けました。

Chapter 1. Configuring Ports - Hortonworks Data Platform

ちなみに、すごく引っかかったのですが、マニュアル上はSpark Thrift Server Portは10015がdefaultだよと記載されているものの、実際の構成後には10016がPortになっています。要注意。

Customizing the Spark Thrift Server Port - Hortonworks Data Platform

以下のように構成できればOKです。

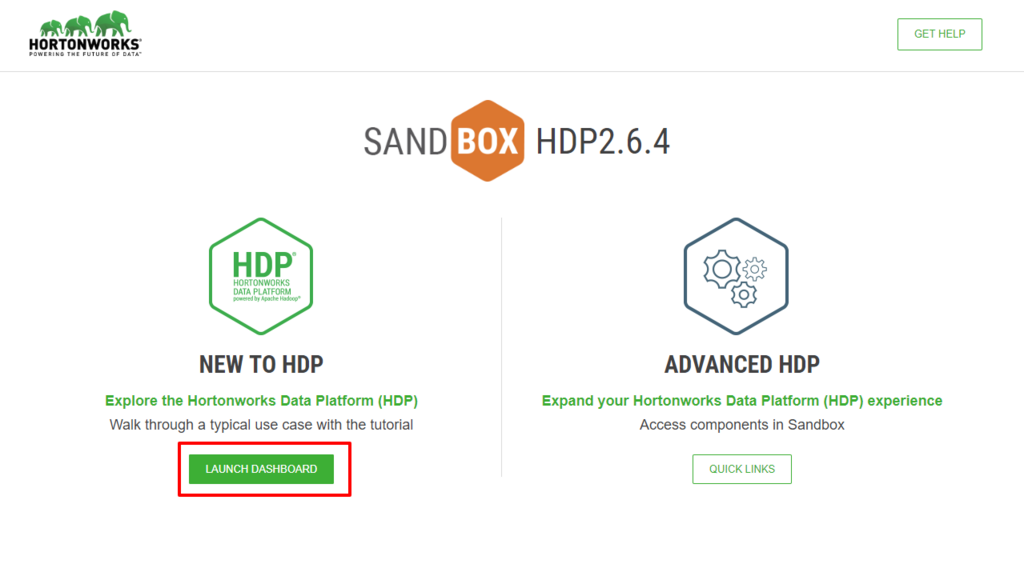

Hortonworks Dashboardへのアクセス

「VMのパブリックIPアドレス:8888」でアクセスできます。

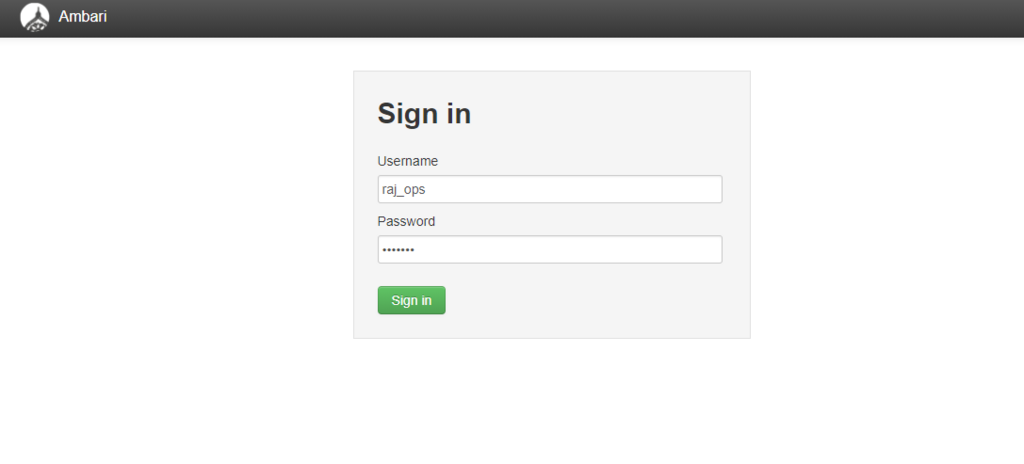

user / password: raj_ops / raj_ops でログイン

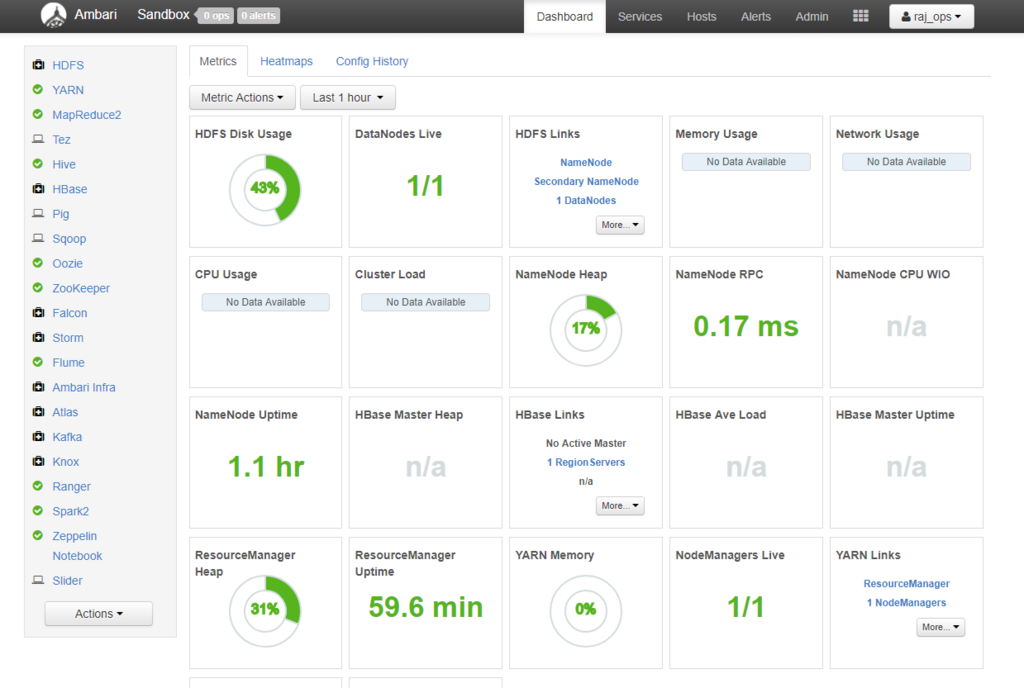

Ambariにログインできました。

あまりログインが早すぎるといろいろと起動中になってしまうので、要注意。

さて、次回実際にもう少し触っていきます。